图片来源:Google

文章来源: Avery, M., Leibbrandt, A., & Vecci, J. (2024). Does Artificial Intelligence Help or Hurt Gender Diversity? Evidence from Two Field Experiments on Recruitment in Tech. CESifo Working Paper No. 10996.

原文链接:

01

研究背景

许多劳动力市场都存在严重且持续的性别差异,特别是在STEM领域,女性的代表性持续不足,尽管已经付出了大量且代价高昂的努力,但这一问题仍未得到解决。这种性别差异给社会带来了问题,并且难以克服,因为代表性不足的群体经常面临偏见,并在初始招聘阶段就遭遇了各种形式的歧视。此外,无论歧视是否存在,仅对歧视的预期就可能阻碍劳动力市场代表性不足群体的参与。

随着人工智能的发展,人工智能在招聘过程中的运用迅速增加,极大地改变了求职者申请以及招聘审核的流程和方式。在招聘中,AI通常被视为一种减少人为偏见的工具,因为它通过标准化决策过程来减少人的主观判断。然而,也有担心认为AI系统可能会延续或放大现有的偏见,特别是当这些算法是基于历史数据训练的,而这些数据本身就可能反映了某些潜在的性别偏见。作者通过两项实地实验来检验AI系统究竟是减少了招聘过程中的性别偏见,还是加剧了性别的不平衡。

02

实验设计与结果

作者分别在劳动力市场的供给方和需求方进行了实验:

1.供给方实验的设计与结果

在第一个实验中(供给方),旨在研究告知申请人他们是由人工智能而不是人类招聘人员进行评估是否会吸引或阻止女性完成技术职位的申请。实验在美国主要招聘网站(如和Dice)发布一个网页开发职位的广告,招聘广告开放给所有美国境内的候选人,并持续一个月。在初步申请阶段,求职者需填写简短的申请表格,提供个人信息、教育背景、工作经验、学习网页开发的方式及当前是否在职等信息,并上传简历。共有726名独立的求职者提交了申请,其中76.1%的申请者为男性,符合该职位所在行业的性别分布。这些申请者构成了实验的样本。

然后作者邀请所有的726名候选人完成在线面试,实验的干预在面试中实施。候选人会收到一封通知他们进入了面试环节的电子邮件,并需要回答一系列在线面试的问题。邮件的内容根据干预的随机分配而有所不同。在AI评估组(AI Supply)中,求职者被告知他们的回答将由AI软件进行评估。而对于人工评估组(Human Supply),求职者会收到完全一样的邮件,只不过被告知他们的回答会被招聘团队评估。实验的最终目标是衡量不同性别的求职者在面试环节的参与情况(即求职者是否完成面试),这可能取决于女性对AI评估的信念,如果女性认为AI有助于减少性别偏见,则在AI干预组中更有可能完成面试,反之,则会减少完成概率。

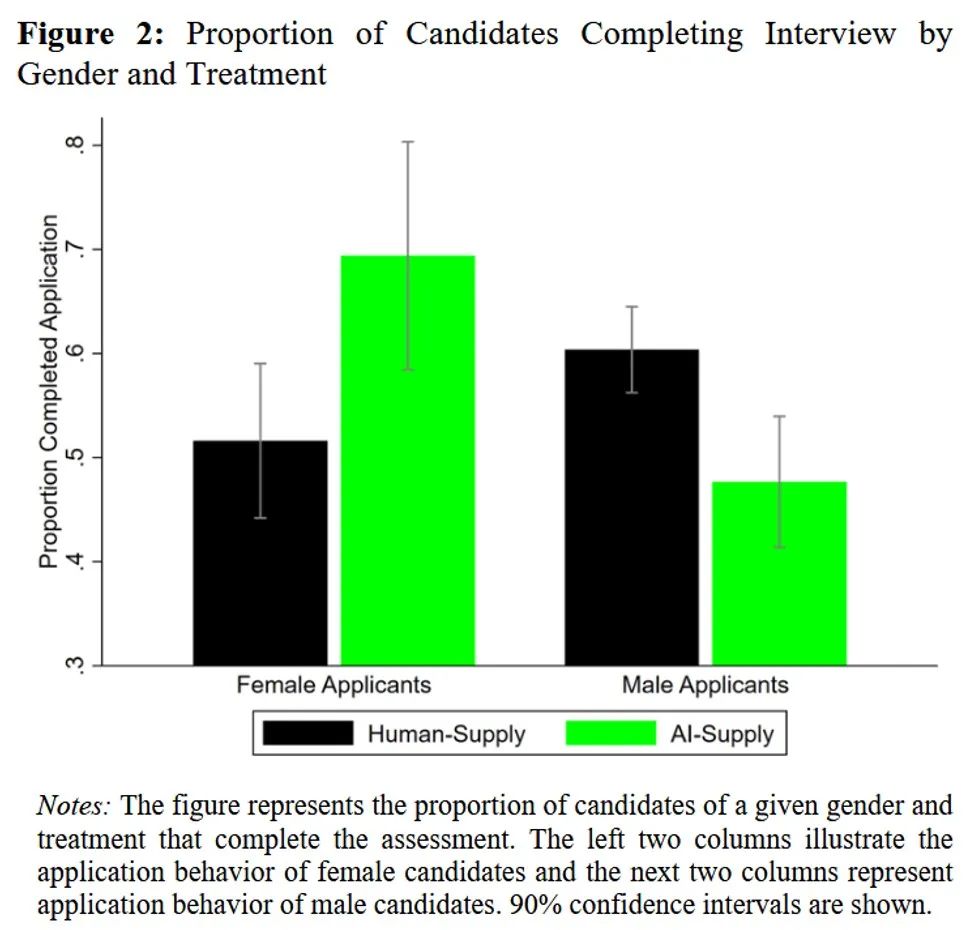

(1)AI评估对不同性别申请行为的影响

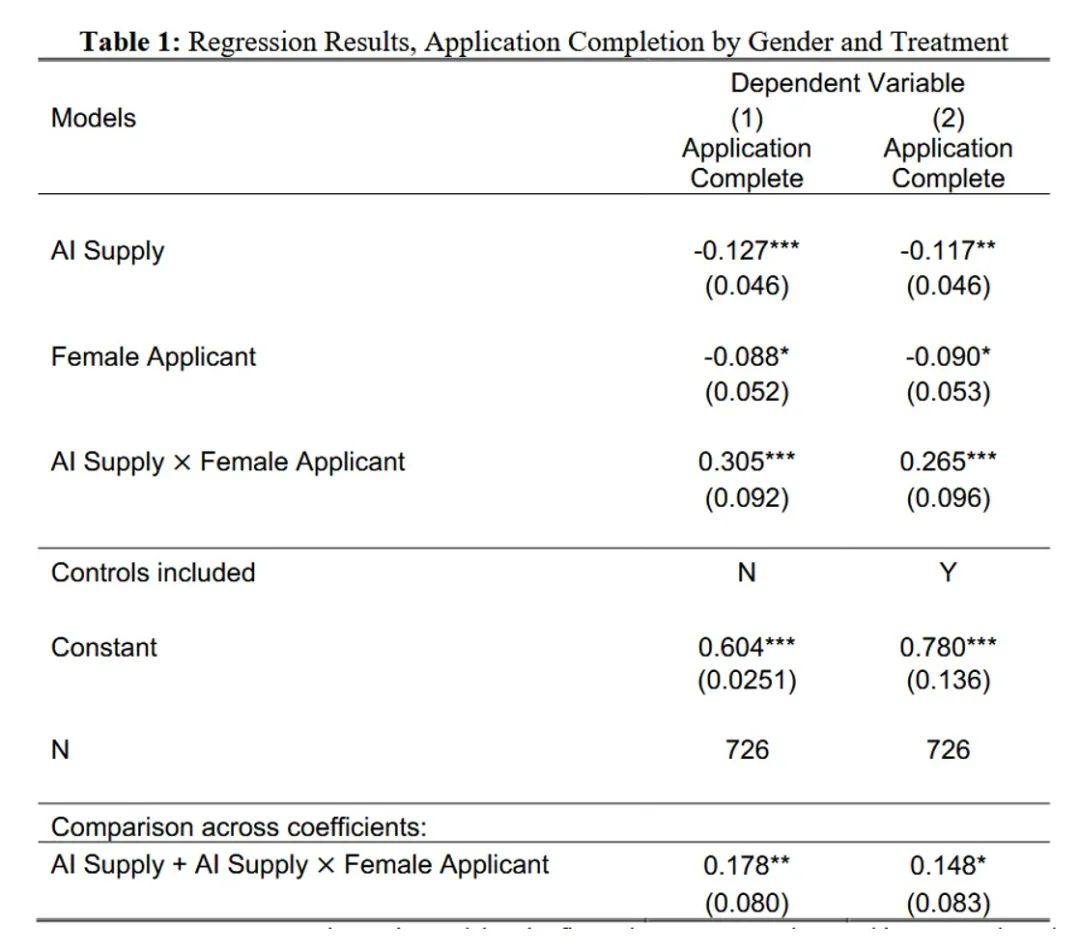

供给方实验的结果如下图所示。当通知求职者面试将由AI评估时,女性完成面试的概率增加了18个百分点(p=0.03),表明女性在知道AI会评估她们的回答后,更倾向于完成面试;与女性相反,男性完成面试的概率下降了13个百分点(p=0.01)。在人工评估组(Human Supply)中,女性完成面试的概率略低于男性(51.6% vs. 60.4%,p=0.09)。

在回归模型中,作者考察了AI评估与性别的交互作用。结果表明即使控制了其他可能与性别相关的因素(如工作经验、学历、编程语言技能等),结果依然稳健,交互项的系数显著为正,表明使用人工智能评估使完成申请的女性相对于男性的比例增加了 27-30 个百分点。结果还表明,使用AI评估后,申请行为的变化导致最终申请者池中的女性比例有所增加。在Human-Supply处理下,最终申请者池中女性占比为22%,而在AI-Supply处理下,这一比例为29%(p=0.11)。因此,与标准招聘评估程序相比,人工智能评估提高了女性申请的完成率,降低了男性的申请完成率,并提升了最后申请者群体的性别多样性。

(2)潜在机制

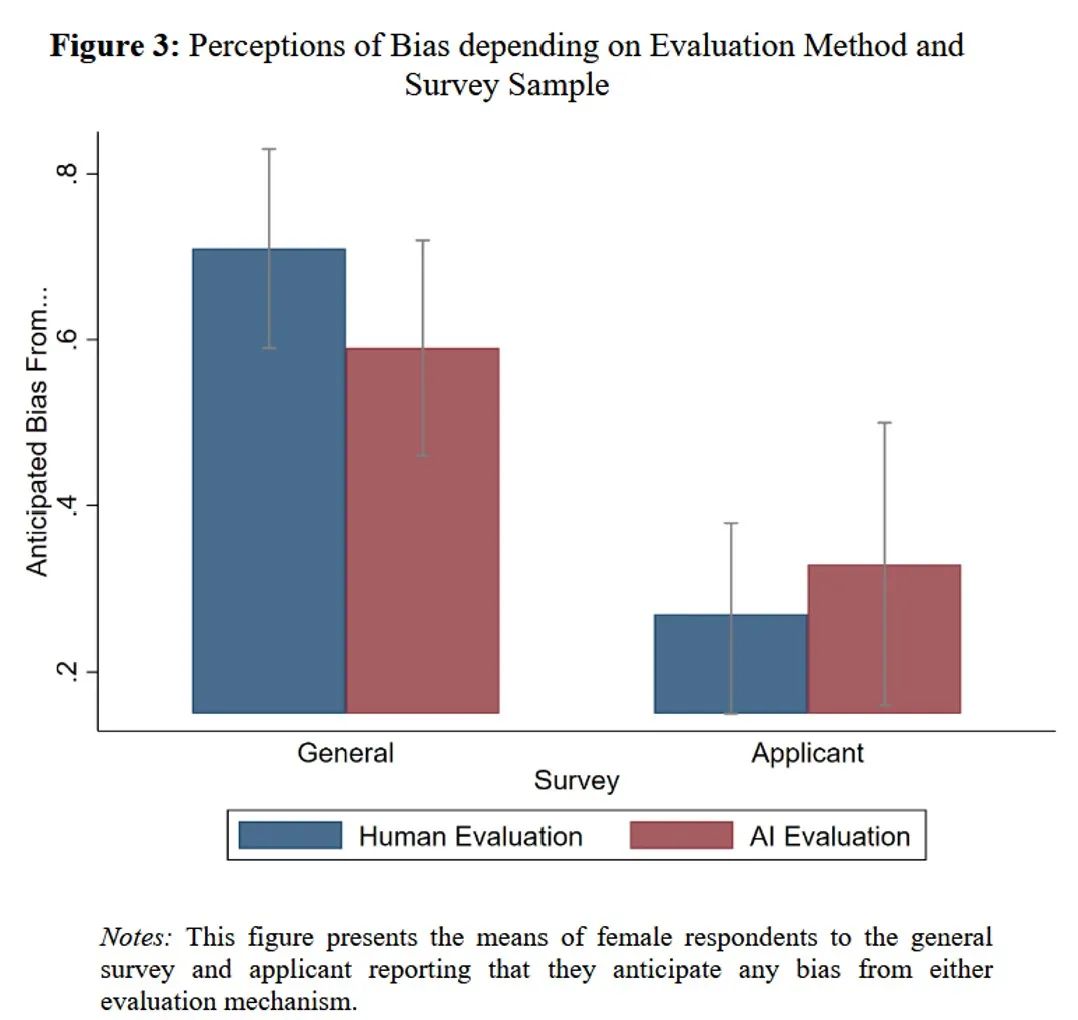

AI被视为减少性别偏见的工具,这可能是女性申请完成率增加的一个主要原因。作者针对美国科技劳动力中129名成年人进行了一项调查(general survey),向受访者介绍了招聘广告中的职位和评估措施,并询问了他们一系列问题,并随机地询问他们对招聘团队和AI评估方式的感受。调查受访者与实际申请者的资质和所在的就业市场相似,因此可以为研究提供有关AI在招聘过程中的潜在影响的真实反馈。

为了更好地了解偏见观念是否真的会影响女性的申请行为,作者在面试评估结束后也对求职者进行了调查(applicant survey),以了解完成申请的求职者对他们分配的评估者所持有的信念。图3展示了女性在两项调查中报告预期偏见的比例,可以看到在一般调查中女性对人类评估的偏见表达担忧的可能性比人工智能评估高出12个百分点,然而,在申请人调查中,在人类和人工智能评估下完成申请的女性同样可能表示担心该评估类型的偏见(diff=-0.07,p=0.49)。这表明预期偏差是理解为什么女性在面对人工智能评估时提高申请完成率的一个重要因素。

2.需求方实验的设计与结果

第二个实验面向劳动力市场的需求方,AI工具评估求职者并将候选人匹配到招聘职位。重点在于评估招聘人员如何在AI评估下判断求职者的表现。

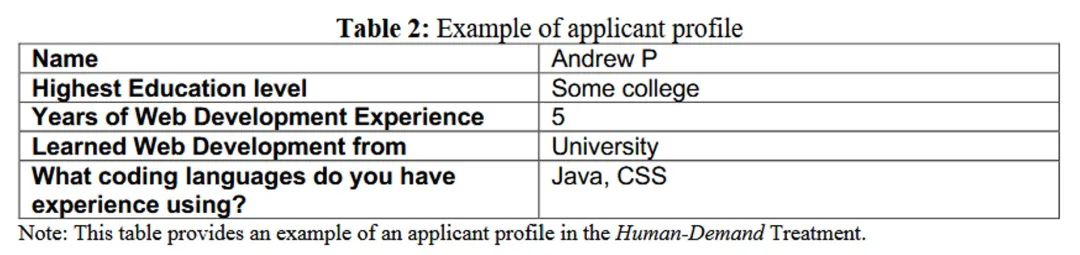

实验招募了来自科技行业具备招聘经验的招聘人员,每位招聘者需完成20分钟的评估任务以获得20美元的报酬。在阶段1,评估者会收到简要的任务描述,并通过几道理解题来确保他们理解任务内容。然后在阶段2,评估者需对4个求职者资料进行评估(2名女性和2名男性,资料随机排序)。每个求职者的资料包括他们在面试中对评估问题的回答以及简历信息(如教育背景、网页开发经验等),表2呈现了一位候选人的资料案例。评估者需根据他们认为该候选人如果被雇佣为网页开发人员后可能的表现来打分,分数范围为0-100。同时被告知他们的评分将直接影响求职者是否能进入招聘流程的下一阶段,并对招聘公司和求职者产生实际影响,以确保他们认真评估每一位候选人。

招聘人员被随机分配到三种干预组中,在控制组中(Human-Demand),招聘者仅看到求职者回答的问题和简短的个人资料。在该组中提供了可能的性别信号(如求职者的姓名),但并未提供AI的评分。AI-Demand组在控制组的信息基础上额外提供AI软件给出的评估分数(满分100分),以检验在AI评分和人类共同作用下的求职者质量判断与单独使用人类评估的效果差异。No-Name组与控制组相同,唯一的不同是求职者的名字被去除,从而消除了招聘者对性别的认知,用于测试在不知道性别的情况下,招聘者如何评估男性和女性求职者。

在招聘人员完成评估后,其还会参与一项后续调查,以收集他们对各个求职者表现的具体看法和评价依据。作者通过这种方式考察AI评估是否会影响招聘人员的决策,尤其是评估者是否因为AI评估而做出不同的判断。

(1)招聘者的评分结果

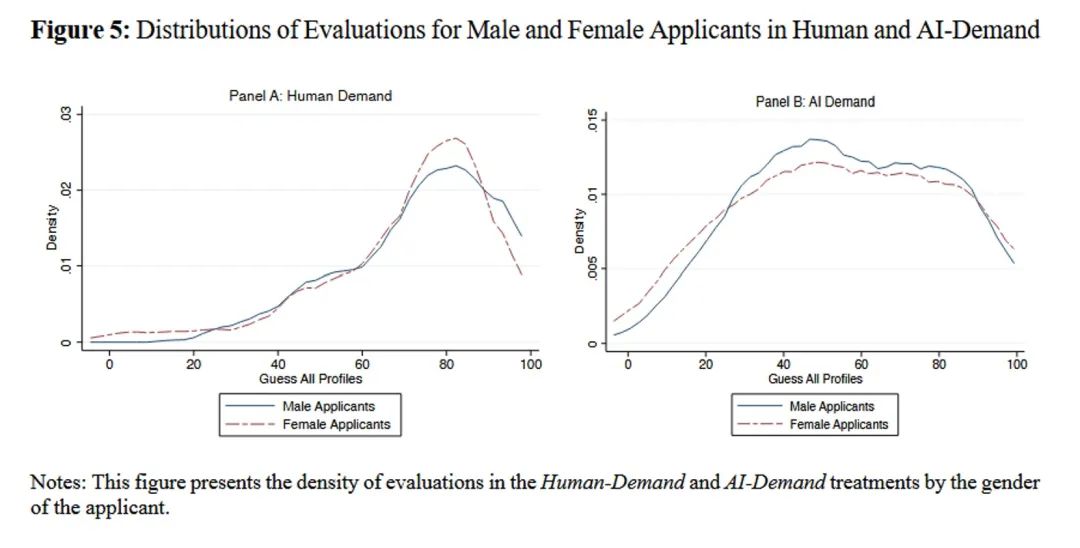

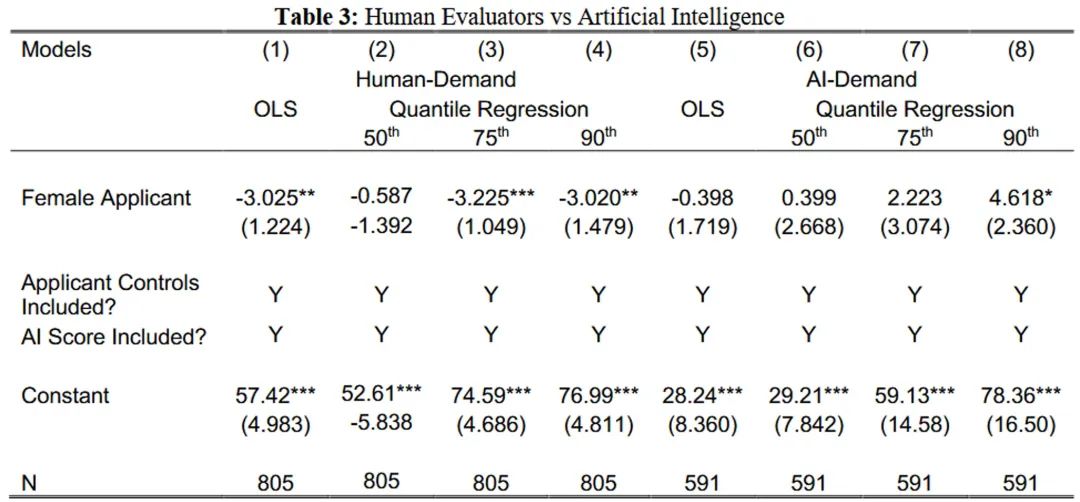

下图报告了招聘者在不同处理组下对申请人的评分结果。可以看出在Human-Demand处理组中,求职者的平均评分为73.06分,男性平均得分为 74.51,而女性得分仅为 71.60,相差 0.15 个标准差(p=0.03),且性别差距在分布的右尾部分更加明显。而在AI-Demand组中,评估者给出的平均评分相对较低,为56.27分,这可能是由于AI评分的平均分数较低(31.25)所导致的。同时,在该组下没有显著的性别差异 (p=0.61):男性得分仅比女性高 1.07分,并与实际AI的得分一致。

OLS回归和分位数回归(50th、75th、90th百分位)的结果也表明,在控制了求职者的特征和AI评分后,Human-Demand组中的女性平均得分比男性低3分,且大部分差异出现在50百分位数以上。而在AI-Demand组中,前50%,25%,10%的中男性和女性的得分基本上都没有显著的差异。

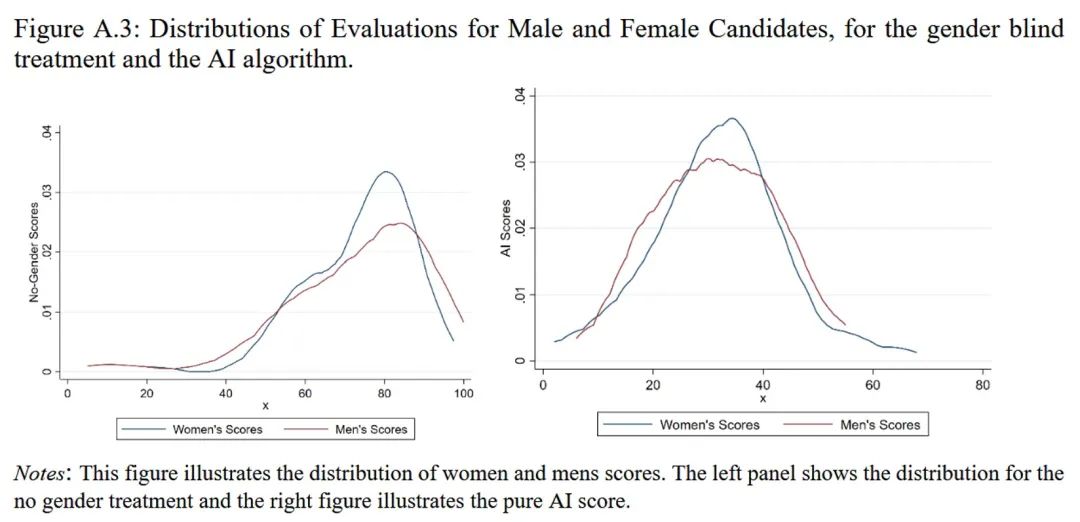

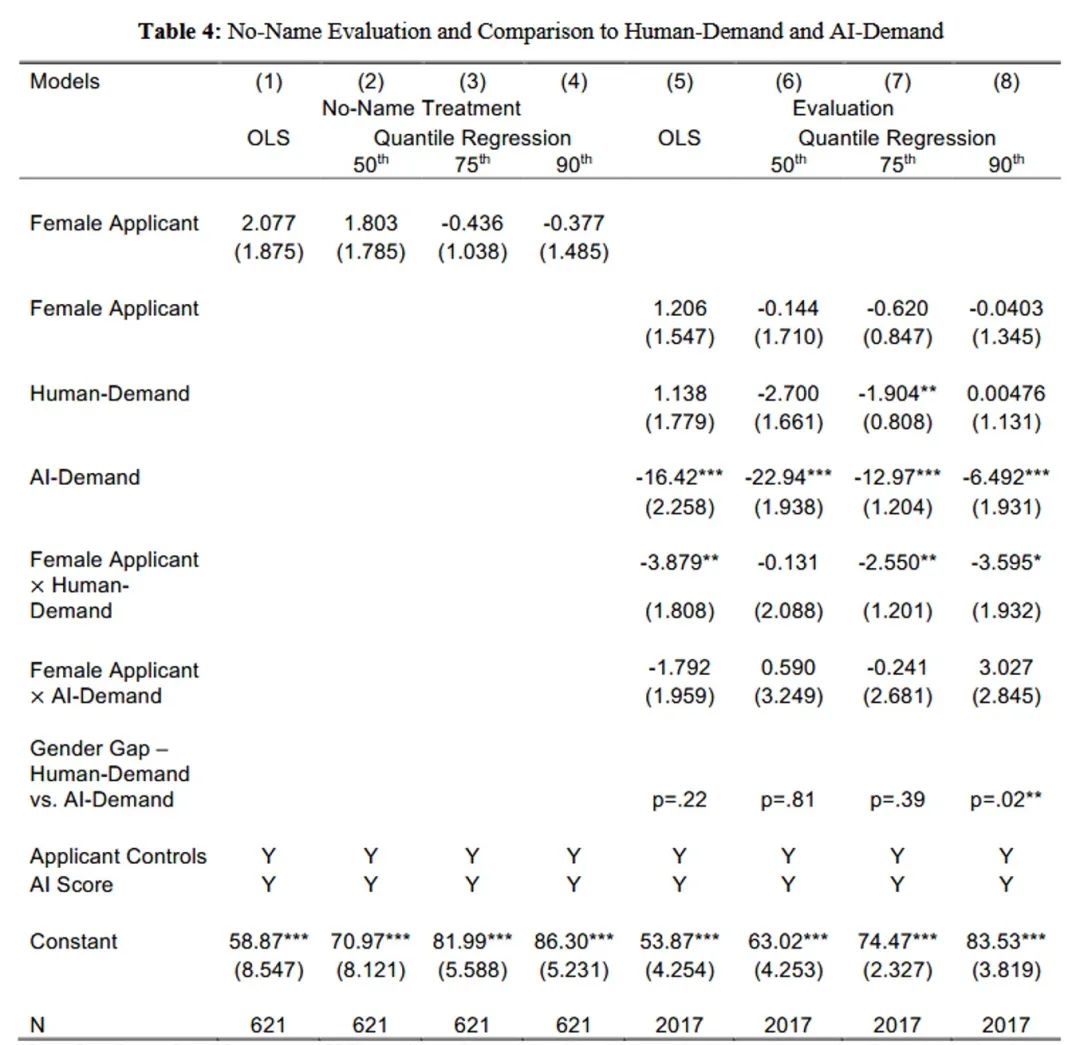

为了了解在Human-demand组中观察到的性别差距是否与性别偏见一致,作者对No-name组的申请人评分进行了回归。结果如表4的第1-4列所示,在 No-Name 组中,分数不存在性别差异,无论是在均值还是不同的百位数上。此外,从表4的第5-6列中可以看出,与No-Name组相比,男性在Human-Demand组中更受青睐,而在AI-Demand组中则没有更受青睐,尤其是在右侧分布的尾部。

尽管AI评分对评估者有一定影响,但大多数评估与AI评分差异较大,只有8%的评估与AI评分相差不到5分,表明评估者并非完全依赖AI评分,而是将其视为有用但不决定性的参考。

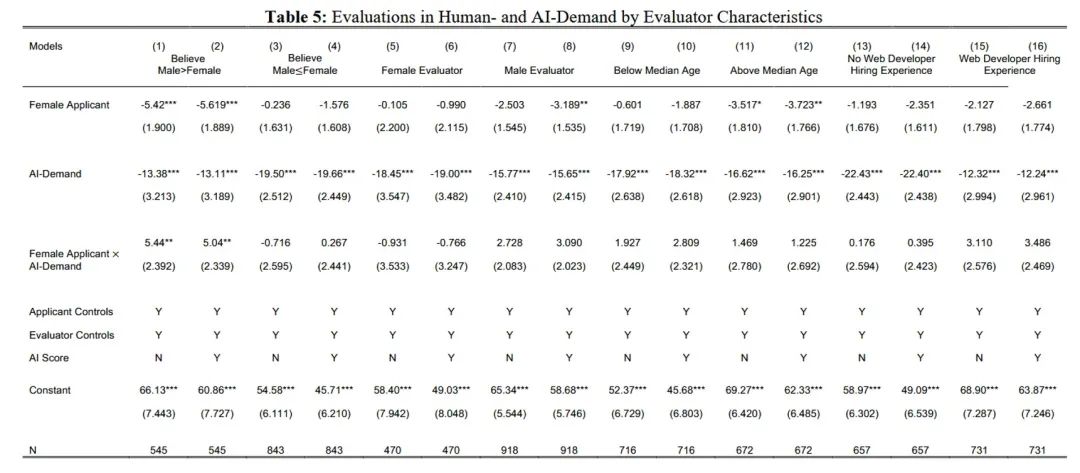

评估者的个人信念和经验在评估过程中扮演着重要角色。表5根据评估者的个人特征进行了划分。结果表明评估者的特征(如对网络开发技能的看法、性别、年龄和招聘经验)对评估结果有一定影响。例如,认为男性在网络开发中比女性更有技能的评估者,在AI-demand组中会对女性评估较低,但在AI-demand中,性别差异消失。认为男女在网络开发技能上相当的评估者,则不受性别影响。

03

AI有多大的偏见才会影响性别的多样性?

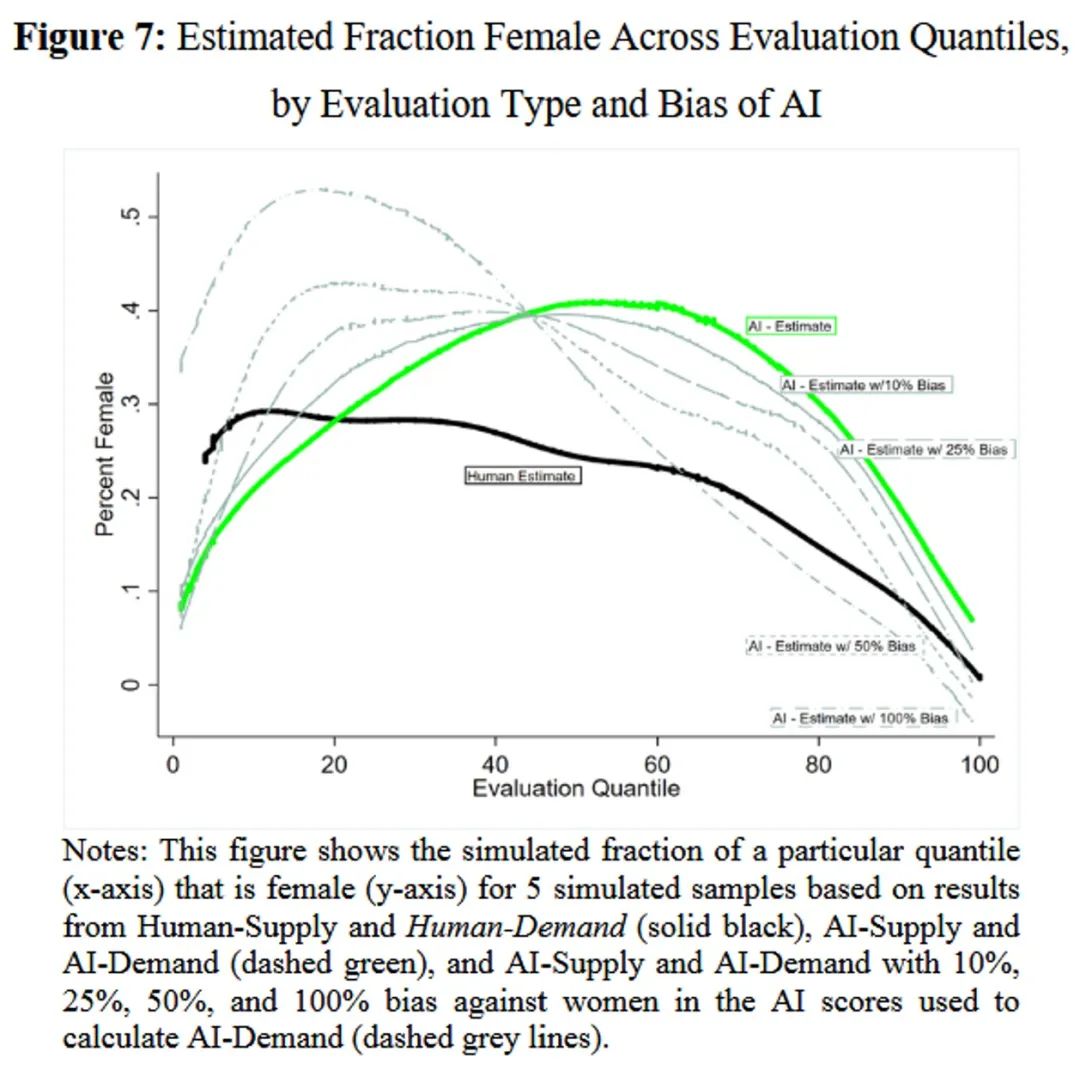

本文的研究结果表明使用的AI工具在评分分布中没有性别差异,因此所有的评分变化来自于人类评估者,而非算法。然而,担心某些AI工具对少数群体(如女性)存在偏见的声音仍然存在。为了估算带有性别偏见的AI工具可能如何影响性别多样性,研究通过假设AI不同程度的性别偏见(10%、25%、50%、100%)来估算偏见对女性申请者的影响。

结果表明,只有当AI工具的性别偏见达到25%时,女性在最具选择性的工作岗位(分布的右尾)中的比例才会比没有AI的情况下更低。即使AI工具对女性的偏见达到100%,AI仍然能够在50th百分位的求职者中提供更高的多样性,表明AI对申请者行为的影响仍然强大。因此,只有在AI工具对女性有非常强的偏见时,才可能对多样性产生负面影响,而这种负面影响主要出现在最具选择性的岗位之中。

04

结论

本文通过在劳动力市场供给方和需求方的两个实地实验发现,AI在招聘中的应用改变了潜在雇员的性别分布,在某些情况下,女性在顶级申请者中的比例超过了原来的两倍。这一变化同时源于女性在供给方和需求方的更好结果。在供给方,AI评估的使用减少了申请完成率中的性别差距。补充性的调查证据表明,预期偏见是女性在AI评估下比在人类评估下更倾向完成申请的驱动因素。在需求方,向评估者提供申请者的AI评分有助于减少传统评估中对女性的偏见。最后,作者表明,只有当AI工具对女性有严重偏见时,才会导致比没有AI时更低的性别多样性水平。

推文作者:常书杰,北京大学西方经济学博士生

Abstract

The use of Artificial Intelligence (AI) in recruitment is rapidly increasing and drastically changing how people apply to jobs and how applications are reviewed. In this paper, we use two field experiments to study how AI recruitment tools can impact gender diversity in the male-dominated technology sector, both overall and separately for labor supply and demand. We find that the use of AI in recruitment changes the gender distribution of potential hires, in some cases more than doubling the fraction of top applicants that are women. This change is generated by better outcomes for women in both supply and demand. On the supply side, we observe that the use of AI reduces the gender gap in application completion rates. Complementary survey evidence suggests that anticipated bias is a driver of increased female application completion when assessed by AI instead of human evaluators. On the demand side, we find that providing evaluators with applicants’ AI scores closes the gender gap in assessments that otherwise disadvantage female applicants. Finally, we show that the AI tool would have to be substantially biased against women to result in a lower level of gender diversity than found without AI.

声明:推文仅代表文章原作者观点,以及推文作者的评论观点,并不代表香樟经济学术圈公众号平台的观点。

0

推荐

京公网安备 11010502034662号

京公网安备 11010502034662号